楽天グループ株式会社は、Mixture of Experts(MoE)アーキテクチャを採用した日本語大規模言語モデル「Rakuten AI 2.0」と、楽天初の小規模言語モデル「Rakuten AI 2.0 mini」を本日提供開始した。

革新的なアライメント最適化手法を採用

「Rakuten AI 2.0」のファインチューニングには、SimPO(Simple Preference Optimization with a Reference-Free Reward)を採用。従来のRLHF(Reinforcement Learning from Human Feedback)やDPO(Direct Preference Optimization)と比較し、シンプルで安定した調整が可能となった。

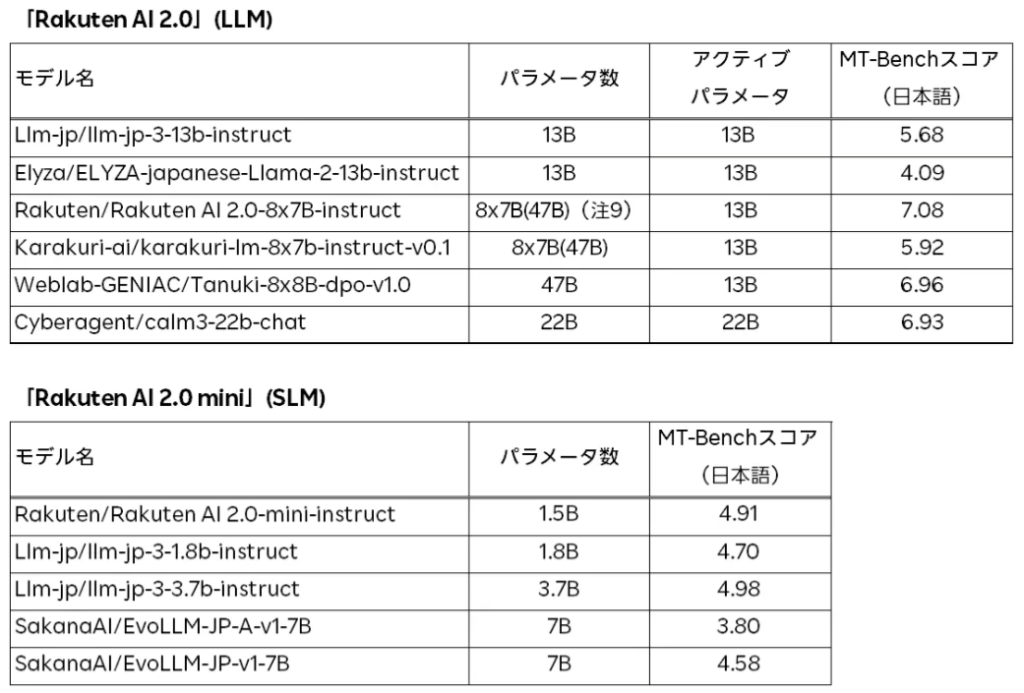

日本語版MT-Benchで最高水準の評価を獲得

楽天は、会話能力と指示追従能力を評価する日本語版MT-Benchを用いて、各モデルの性能を検証。その結果、「Rakuten AI 2.0」および「Rakuten AI 2.0 mini」は、同程度のパラメータ数を持つ他の日本語オープンモデルと比較して、最高水準のスコアを記録した。特にコンテンツの要約、質問応答、対話システムの構築など、実用的なテキスト生成タスクでの優れた性能が示された。

楽天のAI戦略と今後の展望

楽天は、AIを活用した事業成長を推進する「AI-nization(エーアイナイゼーション)」戦略を掲げている。今後も日本市場に最適化されたLLMの開発を継続し、楽天エコシステムの強化を目指す。楽天のChief AI & Data Officer(CAIDO)であるティン・ツァイは、「オープンモデルの公開が日本におけるAI開発の加速につながる」と述べ、AI技術の発展に貢献していく意向を示した。

「Rakuten AI 2.0」および「Rakuten AI 2.0 mini」は、Apache 2.0ライセンスのもと、楽天の公式Hugging Faceリポジトリからダウンロードが可能となっている。